Hadoop和SAP-HANA的用例是不同的,但是在某些情况下,它是推荐的,甚至是必需的,或者是连接两个世界。Hadoop集群运行在由非结构化数据组成的非常大的数据集上,而saphana则专注于分析处理。复制Hadoop数据的ETL过程并不总是一个好的解决方案,淘客app定制,因为它会极大地增加数据库内存需求。但这两种技术的巧妙使用同时得益于较低的存储成本和高速内存处理能力。

有几种方法可以将来自Hadoop群集的数据公开到SAP HANA数据库。不久前,淘客公众号,我写了两篇博客文章,描述了如何使用sapvora和Spark扩展从saphana中的azurehdinsight和azuredatabricks查询数据。但不需要SAP Vora。saphana可以直接连接到Hadoop集群,只需使用ODBC驱动程序或hanaspark控制器。今天我介绍了第一种方法,但是不用担心,一个关于Spark控制器的博客就要来了!

在上一集中,宁波大数据,大数据是干什么的,我已经介绍了如何部署Azure Databricks集群,所以这次我直接跳到配置部分。如果您还没有集群,我建议您先阅读第17部分。

ODBC驱动程序

我使用unixODBC作为驱动程序管理器。默认情况下,它没有安装在我的服务器上,所以我使用Yast添加缺少的组件:

我今天要使用的simbaodbc驱动程序可以在Databricks网站上找到。要访问下载链接,您必须提供您的详细信息,如姓名或电子邮件地址。大约10分钟后,我的收件箱里有了一封新邮件。

SAP HANA数据库运行在Linux环境下。我下载了64位版本并提取了存档文件。

RPM安装也很简单

默认情况下,软件包被提取到/opt/simba/spark目录:

驱动程序库libsparkodbc\u sb64.so位于/opt/simba/spark/lib/64

配置ODBC驱动程序

要配置驱动程序,我们需要一个输入从Databricks集群。它公开了ODBC协议,在Clusters->Configuration->ODBC

下提供了连接详细信息。要建立连接,我们还需要一个可以在Databricks仪表板中生成的个人令牌。点击右上角profile图标下的用户设置:

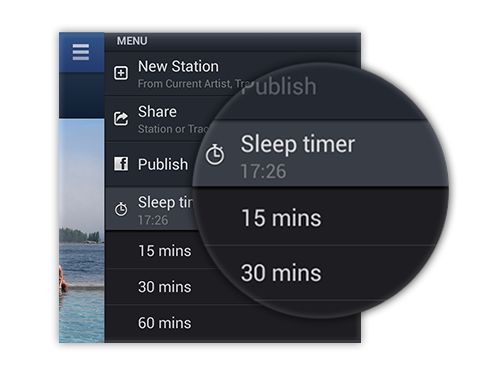

点击Generate New Token并选择有效期。令牌将显示在屏幕上–记住复制它,因为不可能再次显示它。

ODBC配置中继到两个文本文件,该文件应保存在adm用户的主目录中。第一个可以从驱动程序位置复制并存储驱动程序设置。无需更改任何内容。

第二个文件保存连接信息。创建。odbc.ini文件包含以下内容的文件:

unixODBC使用系统变量标识配置文件。修改它们的最简单方法是创建。客户.sh位于主目录中的文件,在数据库用户登录时自动执行。

注销并再次登录以检查当前unixODBC配置。用户数据源应指向。odbc.ini文件我们创建的文件。

测试连接

我认为这是一个很好的时机来停止一段时间,并检查连接到Databricks的工作。有时unixODBC可能很棘手,所以我想确保在saphana中执行任何操作之前正确配置了unixODBC。但是为了测试连接,我们需要Databricks表中的一些数据。您可以将数据帧转换为表,也可以使用用户界面使用浏览器导入新文件。

在上一篇文章中,我介绍了如何将驻留在Azure数据湖中的数据导入数据帧。我们只需添加一行代码即可将其保存为表格:

另一种方法也非常简单。在Databricks仪表板中,单击左侧菜单中的Data,然后选择adddata。在下面的屏幕上,您还可以看到我刚刚使用脚本创建的表:

我使用的数据集在这里可用:

现在您只需将文件拖放到浏览器窗口并调整参数,如表名或表标题:

现在,当我们有一些数据时,我们可以使用ODBC驱动程序查询Databricks群集。

如果您看到SQL命令提示符,大数据应用技术,则表示连接已成功建立,我们可以运行示例查询:

连接工作正常,我们可以继续进行HANA配置。

在SAP HANA中创建虚拟表

今天的post目标是访问SAP HANA数据库中的Databricks群集。我们已经确认连接正常,所以最后一个任务是创建一个新的远程源并将Databricks表引用为虚拟表。

创建一个新的远程源并提供ODBC DSN和用户凭据:

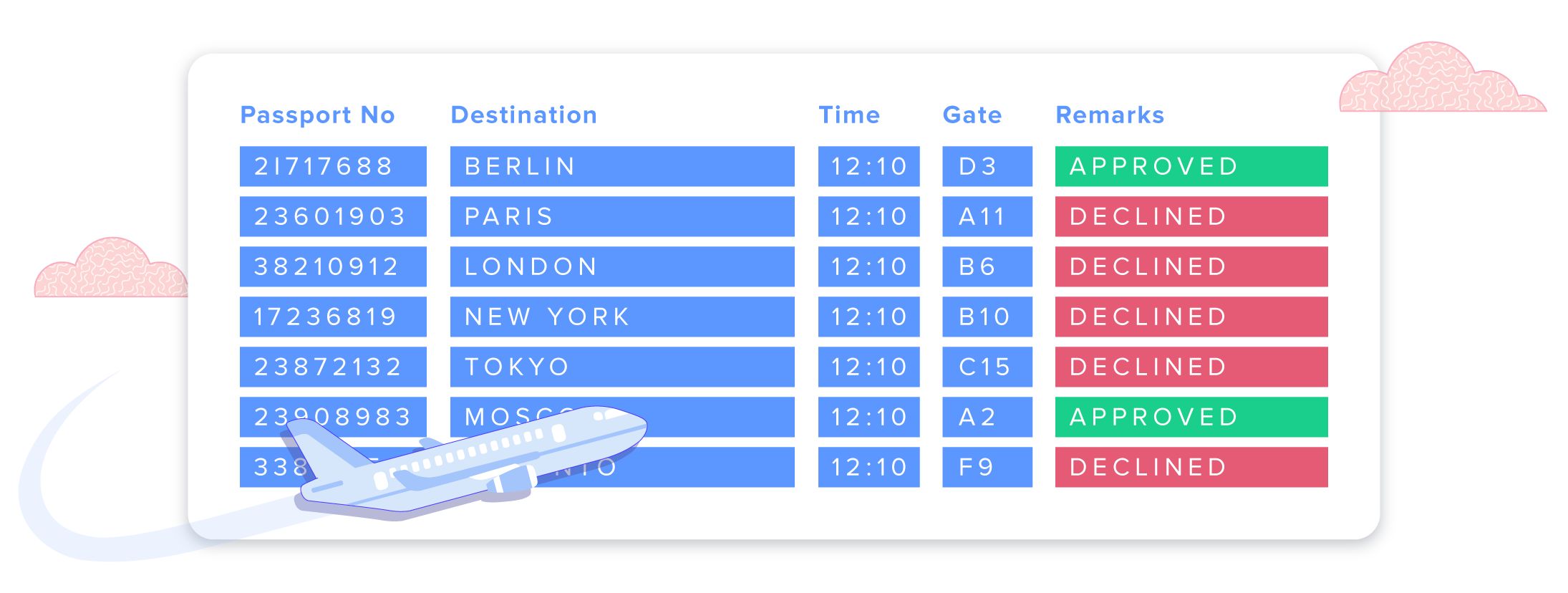

现在您可以扩展远程源以查看Azure Databricks中的可用表:

创建一个虚拟表:

现在您可以根据需要查询它是SAP HANA数据库的一部分